凡分布式系統(tǒng),都不可避免地要應(yīng)對(duì)一致性要求。

但在分布式系統(tǒng)中,很少有產(chǎn)品啟用緩存。因?yàn)槌诵枰捎肗VRAM/NVDIMM來做掉電保護(hù)之外,最重要的是解決分布式緩存的一個(gè)關(guān)鍵問題——Cache Coherency(緩存一致性)。

➤ 這個(gè)問題,戴爾易安信Isilon解決了。

一騎絕塵的橫向擴(kuò)展NAS.....

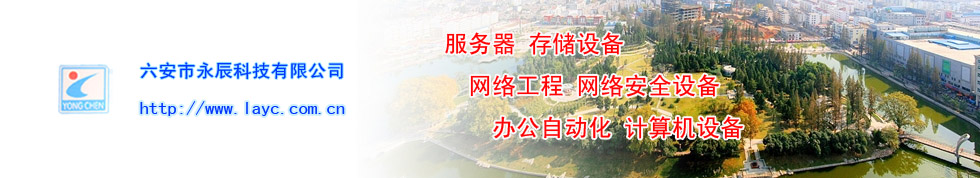

戴爾易安信的Isilon是一個(gè)分布式集群NAS系統(tǒng),支持主流的網(wǎng)絡(luò)文件系統(tǒng)、對(duì)象、REST、SWIFT、HDFS等訪問協(xié)議。Isilon系統(tǒng)分為三個(gè)子型號(hào):F、H、A。

Isilon F800 All-Flash▼

Isilon還擁有一系列的數(shù)據(jù)管理軟件功能,包括:INSIGHTIQ、SMARTPOOLS、SMARTQUOTAS、SMARTCONNECT、SNAPSHOTIQ、CLOUDPOOLS、SMARTDEDUPE、SYNCIQ、SMARTLOCK、ASPERA。

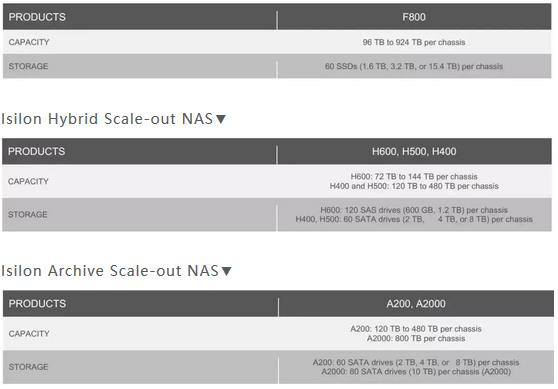

Isilon的核心是OneFS集群文件系統(tǒng)。作為一個(gè)分布式、對(duì)稱式、并行集群文件系統(tǒng),OneFS將傳統(tǒng)存儲(chǔ)體系結(jié)構(gòu)的文件系統(tǒng)、卷管理器和數(shù)據(jù)保護(hù)三層合并為一個(gè)統(tǒng)一的軟件層,從而構(gòu)建了一個(gè)跨集群中所有節(jié)點(diǎn)的單一智能文件系統(tǒng)。

分布式緩存的挑戰(zhàn).....

OneFS屬于對(duì)稱式集群,這意味著任何一個(gè)節(jié)點(diǎn)均可以承載I/O訪問,由此也帶來一個(gè)問題,比如節(jié)點(diǎn)1和節(jié)點(diǎn)2同時(shí)緩存了數(shù)據(jù)A,Host1向節(jié)點(diǎn)1發(fā)起寫請(qǐng)求更改了數(shù)據(jù)A為B,那么此時(shí)節(jié)點(diǎn)2上的數(shù)據(jù)A就必須立即作廢。

我們不妨先看看PowerMax這個(gè)分布式集群SAN系統(tǒng)是如何處理緩存一致性問題的。戴爾易安信的PowerMax采用Hash方式來確定某個(gè)數(shù)據(jù)塊唯一的緩存節(jié)點(diǎn),這樣就不存在緩存一致性的問題,但代價(jià)是需要跨節(jié)點(diǎn)產(chǎn)生數(shù)據(jù)流量,而不僅僅是控制流量,因?yàn)榇藭r(shí)數(shù)據(jù)需要在多個(gè)節(jié)點(diǎn)中傳來傳去。

比如數(shù)據(jù)塊A只能緩存在節(jié)點(diǎn)1,如果節(jié)點(diǎn)2需要訪問數(shù)據(jù)塊A,則先計(jì)算Hash得出數(shù)據(jù)塊A所在的節(jié)點(diǎn),然后向該節(jié)點(diǎn)發(fā)送請(qǐng)求讓其傳遞數(shù)據(jù)塊A的部分或全部到節(jié)點(diǎn)2,再將數(shù)據(jù)發(fā)送給Host端,同時(shí)節(jié)點(diǎn)2將數(shù)據(jù)塊A從其本地緩沖區(qū)刪除,不能作為下次訪問使用,因?yàn)楣?jié)點(diǎn)2根本不知道數(shù)據(jù)塊A在其他節(jié)點(diǎn)上是否已經(jīng)發(fā)生了變化。

Isilon如何實(shí)現(xiàn)緩存一致性.....

這時(shí)大家自然想到,如果數(shù)據(jù)塊A的變化情況能讓集群中所有節(jié)點(diǎn)都知道,廣播出去,不就可以保證數(shù)據(jù)一致性了么?

沒錯(cuò),多核心多CPU其實(shí)也是一個(gè)分布式集群,它就是這么管理緩存的,借助于核間、片間高帶寬低時(shí)延網(wǎng)絡(luò),能夠讓分布式緩存的訪存時(shí)延降低到一個(gè)可接受的范圍內(nèi)。緩存一致性協(xié)議規(guī)定了多個(gè)緩存之間在什么時(shí)候傳送什么消息、以什么方式問答等。比如Intel使用MESIF協(xié)議,AMD使用MOESI協(xié)議。

Isilon的OneFS采用了與CPU類似的緩存一致性協(xié)議實(shí)現(xiàn)了緩存一致性,而開發(fā)這套協(xié)議需要相當(dāng)?shù)募夹g(shù)水平。

Isilon采用Infiniband互聯(lián),以Sockets Direct Protocol (SDP) over InfiniBand (IB)實(shí)現(xiàn)節(jié)點(diǎn)間同步,采用MESI協(xié)議實(shí)現(xiàn)緩存一致性。

MESI表示每個(gè)緩存行的4種狀態(tài):

M – Modified: The data exists only in local cache, and has been changed from the value in shared cache. Modified data is typically referred to as dirty.

E – Exclusive: The data exists only in local cache, but matches what is in shared cache. This data is often referred to as clean.

S – Shared: The data in local cache may also be in other local caches in the cluster.

I – Invalid: A lock (exclusive or shared) has been lost on the data

每個(gè)節(jié)點(diǎn)均記錄本地緩存行的狀態(tài),決定是否要發(fā)出廣播。比如訪問一個(gè)E狀態(tài)的緩存行,就無需通知其他節(jié)點(diǎn),因?yàn)镋表示該緩存行只存在于本地,其他節(jié)點(diǎn)沒有緩存。

不得不說,Isilon通過軟件把CPU集群所采用的緩存一致性協(xié)議搬移到了集群節(jié)點(diǎn)間,這種正宗的分布式緩存實(shí)現(xiàn),在市面上的分布式集群系統(tǒng)中是不多見的。所謂品質(zhì)決定市場(chǎng)表現(xiàn),Isilon之所以能成為全球存儲(chǔ)市場(chǎng)上的橫向擴(kuò)展架構(gòu)典范,與其獨(dú)特的開創(chuàng)性特色是分不開的。